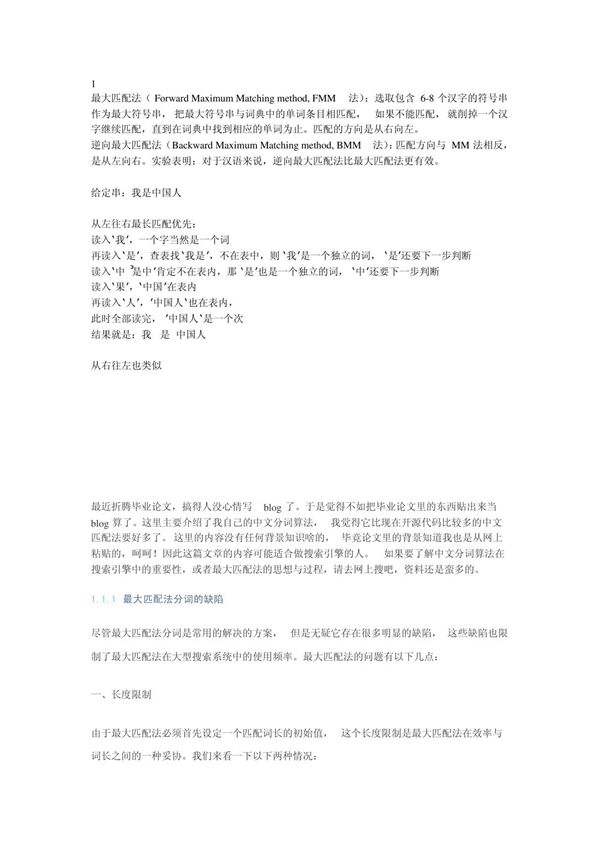

中文分词算法是指将连续的中文文本切分成有意义的词语序列的技术。由于中文书写时词与词之间没有空格分隔,分词成为中文自然语言处理的基础任务。常见的中文分词算法包括:1.基于词典的分词方法-正向最大匹配法(FMM)-逆向最大匹配法(RMM)-双向最大匹配法2.基于统计的分词方法-N-gram语言模型-隐马尔可夫模型(HMM)-条件随机场(CRF)3.基于深度学习的分词方法-循环神经网络(RNN)-长短期记忆网络(LSTM)-注意力机制(Attention)4.混合方法结合词典、统计和深度学习等多种技术中文分词面临的主要挑战包括新词发现、歧义消解和未登录词处理等。目前主流的分词系统通常采用统计与规则相结合的方法,准确率可达95%以上。